=�M�D=

Multicast

& RTP �Y�ɼv���ǿ�

�ؿ�:

-�e��

-Framework

-Microsoft Direct

Show

-Filter�PFilter Graph

-�ϥ�DirectShow

-DS����[�c

-DS���u��

-COM (Component

Object Model)

-Multicast

-RTP/RTCP

-�h�C���ɮ榡

-�t�Ϊ�B�[�c

-�t�γ̫�[�c

-�t�ά[�c��-- DirectShow Filter

-�ǰe��Screen Shot

-������Screen Shot

-��O

-�ѦҸ��

-��v���M�{���X�U��

�� �e��

���M�D���ت��O�N����CCD�PMIC���o���v���P�n��,���Y��MPEG4

(Divx)�榡�A�HRTP�z�LMulticast���覡�A�Y�ɶǵ��h�x�q��,��@���x���OWIN32 PC,�̲ץؼЬO�������ݤ�����WIN32 PC,��p�OWinCE

PDA�BLinux PDA����,�ثe�����x�ۭ���WIN32 PC�C

��ӱM�D�������`�@�����H,�u�@�����T�j����,���O�ORTP�p�աB�h�C���ɮ榡�p�աBMicrosoft

DirectShow�p��,�ӧڭ̤p�եD�n�t�d�������OMicrosoft DirectShow����,�����u�@�O�p������,�b�\�h�譱�����h��s�äF��,�_�h��@�X���{���ҲլO�L�k���X���C

�� Framework

�� Microsoft Direct Show

����ݻP�ǰe�ݼv���^���N�D�n�O��Microsoft Direct Show�F��,

Microsoft Direct Show�]�t�bMicrosoft DirectX����,�n�}�o�{�����e�����n�h�L�n�x������U��DirectX SDK (�ثe�O��8.0a),���SDK���]�t�\�h�������P�{���d��,�j�������N�䴩���O�q�����o���C

Direct Show(��²��DS)��ӬO�HMicrosoft

COM���,DS�i�H���O�ƭ�COM���զ�,�ϥ�DS�N�O��{�������ͩһݪ�COM���,�ù露��I�s�һݪ��}��,�H�U�}�l����DS���Ӹ`�����C

�� Filter�PFilter Graph

Preview

�bDS���̰�¦�����٬�Filter,�C�@��Filter�N����h�C���ƶi��@�ӳB�z�B�J,�bDS�����T�ث��A��Filter,���O��Source

Filter�BTransform Filter�BRender Filter�C

Filters

Source Filter�D�n���u�@�OŪ��Raw

Data ; Transform Filter�D�n�u�@�O���oSource Filter��Raw Data�å[�u�B�z(�q�`��tDecoder����),Render

Filter�D�n�u�@�O���oTransform Filter�B�z��Raw Data�ÿ�X��A�����˸m(��p�g�J�ɮסB��X�v���]�Ƶ���),�����Y�Ϧp�U�ϩҥ�:

![]()

Filter Graph & Filter Graph

Manager

�Ѧ��T��Filter���զ����Ϻ٬�Filter Graph,�N�p�W�y�{�Ϥ@��,�ӦbDS���D�n�x�ޱ���Filter Graph��COM

Component��Filter Graph Manager�C

Filter component

�U��Filter�bDS���O�HCOM��@,�]���ڭ̨ϥ�DS�N�۷���b�{�����ͲŦX�ݭn��Filter Component,���NFilter�զ��@��Filter

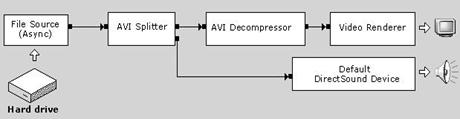

Graph,�̫ᱱ��Media Stream���y�V�N��j���i��,���p�U���d��(����AVI��Filter Graph):

Summary

�z�LFilter Graph�ڭ̥i�H�M���F�Ѩ�h�C���ƬO�p��Q�B�z���CFilter���[�c�����ε{����h�C��B�z��O�ܦ��u��,�{���]�p�v���O�b����Graph,���X�@�ӲŦX�ڭ̦h�C��ݨD��Filter

Graph�C

�� �ϥ�DirectShow

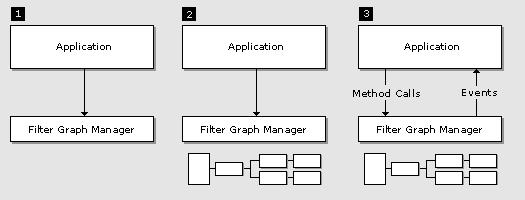

�ϥ�DS���B�J�b����ԲӪ������@�M:

STEP1

�ѩ�ڭ̷|�ϥΨ�COM,�]���@�}�l�ڭ̥������I�sWindows��l��COM

Library��API,�M�Უ�ͤ@��Filter Graph Manager Component�C

STEP2

�A�ӧڭ̴N�n���ͧ���Filter

Graph,�Ӳ��ͪ���k�������,�@�جO�۰ʲ��ͲŦX�h�C�骺Filter Graph(��Filter Graph Manager�Ӱ��o���u�@),�t�@�جO�ڭ̤�ʲ��ͭӭӻݭn��Filter

Component�ñN�ϵ��إ߰_�ӵ�Filter Graph Manager�z�C

STEP3

�̫᪺�B�J�N�O����Media

Stream���ʧ@,���ɻݭn�@��Media Control Component�ӧ@�z,�䤤����FMedia Stream��Stop�BPause�BStart�ʧ@�C�٦�Media

Stream�i��|���ͨǨƥ�(�p����),�o�ɧڭ̥i�H���ͤ@��Media Event Component�ӧ@�z�ƥʧ@�C

�� DS����[�c

�U�ϬO�Ӧ�DS SDK Document,�b���ڭ̥i�H��F��DS�������[�c�C��u��������N�O�ڭ̵{���ү�����,�]�O�W�W�X�g���Ъ������C

�� DS���u��

DS�������W�\�hFilter,���]���i��|�o�ͧ䤣��X�A��Filter�ӧ����ڭ̪��M��,�n�O�o�ͳo�ر��p�ڭ̴N�o�h�g�X�@��Filter�X��,�Ӽg�X�@��Filter�үA�Ϊ��I�������Z�h��,�b�����M�D�N�I��o���Y�h�����D�C�WDS�����w�g���W�@��Base

Class,�~�ӳo��Base Class��Over Ride�@�Ǥ�k�N�|�Ϫ��o�Ӷ}�o�L�{�e���ǡC

�� COM(Component

Object Model)

�ϥ�DS�u�ݪ��p��ϥ�COM(Filter����COM���),���p�G�ݭn�}�oFilter�N�����h�F��COM,�ê��D�p���@COM���,�_�h�N�����~��U�h,�b��²�������@�UMicrosoft

COM�C

COM

COM�ä��O�@�ص{���y��,�]���O�S�w���禡�w,COM�O�@�سW��w�q,COM�W�w�F�s�@�㦳�ʺA������O����k,�]�w�q�F�Τ�ݵ{���P�����@�P�X�@���зǡC�ϥ�COM���{���ܦ��O���ѭ��զ�,�{���]�p�v�]�p�i�H���ƪ��ϥέ��,���n�O�n���s�u�n�N���O��������s,���Τj�T�ק�{��,�����n����@���u�@��e��,��ֳn�馨���C

�N�p�U�ϩҥ�:

Application

![]()

�쥻��@�W�ߪ��{���ܦ��ѳ\�h���զ�,�ӭ��]��b���涥�q�ʺA��,�γ\���ǤH�|�Q�o���N�O��{�������X�ӼҲ�,���O�bCOM��A�BB�BC�BD�BE�O�@�ӥi����G�i�X(���㪺�{��,�q�`�ODLL),�Ӥ��Ostructure

paradigm���{���g�@����,�ӦU���O�z�L�����ӷ��q,�{���i�H�b���涥�q���C

COM Component

COM Component�OWin32�ʺA�s���{���w�Υi�����ɦs�b���i����{���X,�HCOM�W��зǩҼg�X�Ӫ�����,�ڭ̴N�٬�COM

Component�C

Summary

�bDS���Ҧ���Filter���O�HCOM�s�b,�b���ڭ̤w�g�i�H�ݨ�COM���@�Ǧn�B,�N�O�e�����ת��u�ʡC�L�n���\�h�N���O�HCOM����,�pOLE�BActiveX���O�غc�bCOM�W��,COM���ت��O�F���n��IC�z�Q�C

�� Multicast

Preview

�b���������ǰe�Ҧ��i�H�����T��,Unicast�BBroadcast�BMulticast

,Unicast�ݩ�@��@���ǰe�覡 ,Broadcast�O�����������ǰe,Multicast�O�����������S�w�X�x(Multicast Group)���ǰe,Multicast����@�]�i�H�aUnicast��Broadcast��@�X��,���O�o�ؼ����覡�|�D�`���O�����귽�C

Multicast�`���Ω�h�C��譱(�pVOD),�Ӧ������h�C��ǰe�O�HMulticast�Ӷǰe,���[�J�PMulticast

Group���q���i�H�������ݦh�C��C

Mbone(Multicast Backbone)

�Y�n�U����ব�e���y�ʪ�multicast�ʥ]�A�N�ݭn��router�Ψ䥦�w��]�n��䴩multicast�ʥ]����e�ʧ@�A���Y�����u�䴩unicast�覡���ǰe�A�o�ɭԭY�ϥΦh�}�ǿ鰩�F����(Multicast

Backbone, MBone)�A�h�ڭ̥i�H�Ǧ��F������h�}�ǿ骺�ت��C�{�b�@�ɤW�w�g�\�\�h�h��MBone�����C�]��Mbone�ޤJ�F�q�D(Tunnel)�������C�ƹ�W�AMbone�O�@�ӵ������������F�AMbone�ǥѳq�D�N�@�ӭӪ��h�}�ǿ骺����(Multicast

Island)�s�_��

�Y�n�U����ব�e���y�ʪ�multicast�ʥ]�A�N�ݭn��router�Ψ䥦�w��]�n��䴩multicast�ʥ]����e�ʧ@�A���Y�����u�䴩unicast�覡���ǰe�A�o�ɭԭY�ϥΦh�}�ǿ鰩�F����(Multicast

Backbone, MBone)�A�h�ڭ̥i�H�Ǧ��F������h�}�ǿ骺�ت��C�{�b�@�ɤW�w�g�\�\�h�h��MBone�����C�]��Mbone�ޤJ�F�q�D(Tunnel)�������C�ƹ�W�AMbone�O�@�ӵ������������F�AMbone�ǥѳq�D�N�@�ӭӪ��h�}�ǿ骺����(Multicast

Island)�s�_��

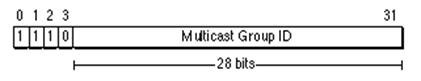

Multicast Group Address

Multicast Group Address�w�bClass D IP,�p�U��:

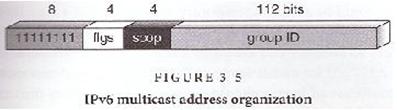

Ipv6���榡,�p�U��:

�� RTP/RTCP

Preview

RTP�w��ݭn�ǰe�Y�ɸ�ƪ�application�A���O�v���A�n���A��������K���A���ѤF�bmulticast��unicast�W�A�I���I���ǿ�\��C

RTP�S���O�d�귽����O�A�礣�O�ҧY�ɪA�Ȫ�OoS�C��RTP�i�P�t�@�����w(�YRTCP)���X�A�Ӻʴ���ƶǿ骺���p�A�H�μW�[�@�DZ���P�ѧO���\��C

Application�@�볣�bUDP���W�]RTP�A�o��̳����ѤF�������ǿ�\��Q�M�ӡARTP�]�i�H�P��L�A�X���U�hprotocol�@�_�B�@�C

�b�DzΪ�protocol���A�Y�n�W�[�s���\��A�u���Nprotocol��o��@��ơA�άO�[�J�@�ӻݭn���R���ﶵ����C���P���O�ARTP�u�n�ק�Ϊ̼W�[header�N�i�H�F��ت��C

�{����Internet���ҡA�õL�k���������Y�ɪA�Ȫ��n�D�C�ϥ�RTP���e�W�A�ȡA���O�v���A�i��|�v�T�䥦�����A�Ȫ�QoS�C�]���A�{���]�p�̥����Ĩ��@�DZ��I�A����n���A�ȧQ���W�e�C

�s���n���|ij

�@�a���q�������̷Q�ǥ�multicast�ǹF�n�����覡�A�i��@���u�W�|ij�C�|ij���D�u�z�L�Y�ذt�m������A��o�F�@��multicast address�A�H�Τ@��port�A�䤤�@��port�O���FRTP(�ǰe�n��)�A�t�@�ӫh�O���FRTCP(�ǰe����packet)�C�o�Ǧ�m�Pport����T�|�������Ҧ��Q�[�J�|ij�����q�����C

�ϥ��n���|ij�{�������q�����A�i�e�X�@�p�����n����ơA�C�@�p����ƫe�|�Q�[�WRTP��header�CRTP header�|���X�C�@��packet�ҥ]�t����ƬO�Τ������Y�覡�A���OPCM, ADPCM, LPC�K���C�b�|ij���L�{�����A�ǰe�n����ƪ����q�����A�i�H�����n�������Y�覡�A�H�t�X�g�ѯ��W�s����Internet�����s�[�J�̡A�άO������ö밵�X�����C

�p�P�䥦packet�����@��AInternet���Ӥ]�|��packet�A�άO�Npacket�����ǥζáC���F�B�z�o�Ƿl�`�ARTP header�|�]�t�ɶ�����T�A�H�Τ@��sequence number�C�p���@�ӡA�Ҧ��[�J�|ij�������N�i�H�̦��ӭ��զ��쪺packet�A�Ʀܦ��p���h��packet�C

�]���b�|ij���L�{�����A���q�����̥i��|�[�J�����}�|ij�A�ҥH���D�Y�H�b��ɥ[�J�A�٦��L������ƪ����p�A�|�O�ܦ��Ϊ��C���F�F��o�ӥت��A�C�@�ӷ|ij�W��application�A���|�bRTCP��port�W�A�w���s���]�t�ϥΪ̦W�٪�reception report�CReception report�|���X�ǰe�n����ƪ������A�Q�������{�צp��A�]�i�H�Ψӱ���A�X���n�����Y�覡�C���M�A���F�ϥΪ̦W�١A�䥦���Ѹ�T�i�������W�e������A�Q�[�Jreception report�C���Y�H�Q���}���@�|ij�Aapplication�N�e�XRTP BYE packet�C

�n���P�v���|ij

�p�G�n���P�v�����Q�ϥΦb�|ij���Aapplication�N�ϥΨ��UDP port pair�A�H��(�ε�)���multicast address�A���O�Ӷǰe�n���P�v����RTP�MRTCP�C�M��RTP�èS����k�����N�n���P�v����session�����X�A���Dparticipant�b�n���P�v����RTCP packet���A���ϥάۦP��CNAME�C

�N�n���P�v���H���P��session�Ӷǰe�A�䤤�@�ӭ�]�O�A���\�[�J�|ij���H�A�u��ܱ����䤤�@�شC��C

���M�n���P�v����session�O���}���A���O�P�B�Ƥ��M�i�H�ǵ�RTCP packet�����ɶ���T�ӹF��C

Mixer

�b���e����ӱ��p���A�ڭ̰��]�Ҧ���participant������ۦPformat���C���ơC�M�ӡA�o�o���O�������T���C

�Q���Y�@�ϰ쪺�H�O�z�L�C�t�u���s����Internet�A�Ө䥦�ϰ쪺�H�h�O�z�L���t�u���s����Internet�C�P��j���Ҧ��H���ϥθ��֪��W�e�ARTP��i�b�a��ijt�������B�A��m�@�ӦW��mixer������C

Mixer�|���N���쪺packet�@�P�B�ƥH����packet�A�M��N�o�ǭ��չL��packet�V�M���@����Ƭy�A�̫�A�N���Y�覡�אּ�A�X�C�t������format�A�óz�L�C�t�u���N�sformat��packet�ǰe���C�t��������participant�C

�bRTP��header���A�|���@�ؤ�k�i�H��mixer���ѨC�@�ӲV�M�L��packet���ǰe�̡A�p���@�ӡAreceiver�N�i�H���Dpacket�O�ѽֵo�X�Ӫ��C

Translators

�p�G����participant�O�z�L���t�u���s����Internet�A�i�O���䴩IP Multicast�A���O�QFirewall�PInternet�j���A�]��Firewall�~��packet���L�k�i�JFirewall�����C�b�o�ر��p�U�ARTP�N�ϥΤ@�ӦW��Translator������C

Translator������O�w�m���Translator�A�@�ӦbFirewall�~���A�@�ӦbFirewall�����C�~����Translator�ǰemulticast packet�A������Translator�h�z�L�w�����D����o��multicast�A���᤺����Translator�A�N�o��multicast packet��e��Firewall����participant�C

�䥦�γ~

�b�@�Ӽv���|ij���Amixer�i�H��C�ӤH���v�������Y�z�����A�M��N���̦X������@�Ӹ�Ƭy�A�Ӽ����s�骺���H�C

�p�G�b�@�ӻ��Z�|ij���A����s�H���O�ϥΤ��P�����hprotocol�A�Ҧp�@�s�H�ϥ�IP/UDP�A�t�@�s�H�ϥ�ST-II�C�άO�v�������Y�覡�O�@��packet���ۤ@��packet�A�Ӥ��ݭ��թβV�M�C���ɡATranslator�]�i���W�γ��C

RTP�M���W������

RTP packet: �@�Ӷ}�Y��RTP header��packet�A�Y��RTP packet�C�q�`�b���hprotocol���A�@��packet�u�]�t�@��RTP packet�A���z�L�@�ǯS�O��encapsulation��k�A���hpacket�]�i�H�]�t�@�ӥH�W��RTP packet�C

RTP payload: �bRTP packet���A�u���n�ǰe����ơA�Y��RTP payload�C�Ҧp�b�v���|ij���A�v����ƴN�ORTP payload�C

RTCP packet: �@�Ӷ}�Y�ORTCP header�A�᭱���۱����ƪ�packet�A�Y��RTCP packet�C�q�`�\�hRTCP packet�|�Q���X�A�A�[�W���h��header�A�ӵ��X�᪺RTCP packet���|�Q�����bRTCP header����length���C

Port: ��RTP�Q�ǰeRTP packet�PRTCP packet��P�@��IP Address�ɡAport�N�i�H�ΨӰϤ��ت��a�����P�C

Transport address: �@�볣�OIP Address�[�WUDP port�Cpacket���O�q�@��source transport address�Ǩ�@��destination transport address�C

RTP session: ���C�@��RTP�ϥΪ̦Ө��ARTP session�O�Ѥ@��destination transport address�w�q�Ӧ�(�@�Ӭ��FRTP�A�t�@�Ӭ��FRTCP)�C�n�`�N���O�A�@�Ӧh�C��|ij���A���P���C���Ƴ̦n�b���P��RTP session���ǰe�C

Synchronization source

(SSRC): SSRC�O�@���H��������ѧO�ȡA�ηN�O�Ϥ@��RTP session����participant�����W�@�L�G���ѧO��T�C���O�P�@�ӨϥΪ̦b���P��RTP session���A�ä��@�w�n�ΦP�@��SSRC�C

Contributing source

(CSRC): ���e���Lmixer�i�H�N���P�ӷ���RTP packet�V�M���P�@��RTP packet���C���ɡARTP�]�|�bRTP header�������P�o��packet������SSRC�A�ӳo��SSRC�X�_�ӴN�s��CSRC�C

End system: �p�G�@��application�i�H���ͤ��e�Q�]�bRTP packet���Q�ǰe�A�άO�i�HŪ��RTP packet�������e�A�N�i�H�Q�٬�End system�C

Monitor: �p�G�@��application�i�H�����b�@��RTP session���Ҧ�participant�e�Ӫ�RTCP packet�A�N�i�H�Q�٬�Monitor�CMonitor�i�H�Q���ئbEnd system���Q�]�i�H�������ѻPRTP session�A�o��Monitor�Q�٬�Third Party Monitor�C

RTP header�����T�w���

|

0 |

1 |

2 |

3 |

||||||||||||||||||||||||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

0 |

1 |

|

V=2 |

P |

X |

CC |

M |

PT |

Sequence number |

|

Timestamp |

||||||

|

Synchronization

source (SSRC) identifier |

||||||

|

Contributing

source (CSRC) identifier �K�K |

||||||

RTP header��컡��

Version (V): ����RTP�������C

Padding (P): �p�G�o�����Q�]�w�ARTP packet���ݱN�|�]�t�@�ӥH�W��padding octets�A�����̨ä��ORTP payload���@�����A�Ӧbpadding���̫�@��octet�|�O���b�o��RTP packet�����h�֭�octet�C�b�Y�����Y�t��k�A�άO���h���q�T��w�Apadding���i��|�Q�Ψ�C

Extension (X): �p�G�o�����Q�]�w�A�b�T�w��RTP header���٭n�[�W�@�� header extension�C

CSRC count (CC): ����CSRC���ӼơC

Marker (M): �Χ@���n�ƥ�A���O�v����frame���ɭ��ѧO�ȡC�o�ӭȪ������O�d��application�h�B�z�C

Payload type (PT): �Ψөw�qRTP payload��format�A��format�������h�O�d��application�h�B�z�C

Sequence number: �C�e�X�@��RTP packet����Asequence number�N�|�W�[�@�CSequence number�]�i�H�Qreceiver�ΨӰ���packet loss�A�H�Ϋ�_packet�����ǡC

Timestamp: �ΨӰO��RTP packet�Ĥ@��octet�QŪ�������ˮɶ��C

SSRC: �p�P�e�����w�q�C�n�`�N���O�A�p�G�@��source���ܥ���source transport address�A��������ܤ@�ӷs��SSRC�C

CSRC list: �p�P�e�����w�q�C�n�`�N���O�A�p�G�@��RTP packet�]�t15�ӥH�W��CSRC�A�u��15��CSRC�i�H�Q�ѧO�C

RTP header�`�N�ƶ�

�e�Q�G��octet�@�w�|�X�{�b�C��RTP packet�Q��CSRC list�u��packet�g�Lmixer�~�|�Q��J�C

Multiplexing�`�N�ƶ�

�n���������O�A�p�G�@��protocol�Q���IJv���B�@�Amultiplexing���I���Ӻɶq��֡C

�bRTP���Amultiplexing�O�ǥ�destination transport address�ӧ����C�Ҧp�@�ӥ]�t�v���P�n�������Z�|ij�A�n���P�v���N�b���P��RTP session���Q�ǰe�C�W�ARTP�ä��Ʊ�v���P�n�������P����Ʀb�P�@��RTP session���Q�ǰe�A�M��A�ھ�payload type��SSRC��demultiplex�C

Multiplexing�i��J�쪺���D

�b�P�@��RTP session���ϥΦP�@��SSRC�|�y���H�U���Ӱ��D�Q�ܩ�b�P�@��RTP session���ϥΤ��P��SSRC�A�N�i�קK�e�T�Ӱ��D�A�����|�J����Ӱ��D�G

�p�G�bsession�B�@���L�{���A��payload type�����ܡA�N�S����k���D�O���@���ª�payload type�Q���N�C

�i��ݭn���P���p�ɤ覡�A�H��sequence number�Ŷ��C

���ORTCP sender report�άORTCP receive report�A���w��P�@��SSRC�A���u��y�z�@�ӭp�ɤ覡�A�H�Τ@��sequence number�Ŷ��C�ӥB�A�S��payload type���C

RTP mixer�S����k���X���ۮe��media�C

�p�Greceiver�u�Q����RTP session�䤤�@��media�A�N�O���i��C���~�Areceiver application�Q�Τ��P��process�h�������P��media�A�]�O���H�F�����C

RTP header extension�榡

|

0 |

1 |

2 |

3 |

||||||||||||||||||||||||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

0 |

1 |

|

Defined by profile |

length |

|

header extension �K�K |

|

RTP header extension��컡��

defined by profile: �Ψӱ����@��identifier��parameter�C�H���\�n�椬�@�Ϊ�implementation�i�H�Τ��P��header extension�h����Q�Τ��\�@�ӯS����implementation�i�H�Τ@�إH�W��header extension�h����C

Length: �ΨӰO���bextension��32-bit word���ӼơC

RTP header extension�`�N�ƶ�

Extension����O���F����s��payload-format-independent�\��A�����ǥ\��i�H�bRTP header���[�J�ݭn����T�Q���O�A�Y�u�O�Y��payload format�һݭn���ӥ~��T�A�h���y�ϥ�header extension�A�ӬO���ӥ]�t�bRTP packet����payload section�C

RTCP (RTP Control Protocol)

RTCP²��

RTCP����z�N�O�A�ϥλPRTP�ǰepacket�@�˪��ǰe����A�C�j�@�q�ɶ��N�ǰecontrol packet�C

RTCP�T�j�\��

n

RTCP�D�n���\��O�F�Ѹ��distribution��quality�C�A�t�Xdistribution����A���OIP Multicast�A�N�i�H��network service provider�o����ڤW�S���[�JRTP session�����A�h�E�_�����W�����D�C

n

RTCP�]�t�@�Ӥ��ܪ�RTP source��transport-level identifier�A�s��canonical name�άOCNAME�CReceiver�̾aCNAME�Ӱl�ܨC�@��participant�CRTP�]�ϥ�CNAME�b�@�լ�����RTP sessions���A�N�ӦۦP�@��participant���h��data stream�@�pô�C

n

�e����ӥ\�ೣ�ݭn�Ҧ���participant�ǰeRTCP packet�A�ҥH���A���j�q��participant�A�ǰe���t�v�N�n����C�z�L�C�@��participant�ǰeRTCP packet����Lparticipant�A�Ҧ���participant�i�H�[��{�bparticipant�`�ƥءA�ӳo�ӼƥشN�Ψӭp��ǰeRTCP packet���t�v�C

RTCP packet����

RTCP packet�i�H�]�t�H�U���ظ�T�Q

n

SR: ����sender��reception statistics�C

n

RR: ����receiver��reception statistics�C

n

SDES: ����source����T�A���OCNAME�C

n

BYE: ���X�Y�@participant�����}�C

n APP: ���X�Y�@application�S����functions�C

RTCP�`�N�ƶ�

n

�C�@��RTCP packet�̫e�����|���T�w�������A�M��ھ�packet���������P�A���۪��פ��P����ơA���`bit�Ƴ��O32�����ơC

n

�h��RTCP packet�i�H���X�A�Ӥ��ݭn����separator�C

�C�@��RTCP packet�@�w�n�]�tSR/RR�P��CNAME��SDES�A�ӥBSR/RR�@�w�O�b�̫e���C

�� �h�C���ɮ榡

�@��Q��RTP�Ӱ����T���γq�`�|�����Session�Ӱ�,�@��Session�t�d�n���ǰe,�t�@�ӫh���v��,�o�˪����p���U�����Ҽ{�v���P�B�����D�C�ӳo���O�ǰe�@�Ӥw�g���t���n���v����Raw

Data�L�h(AVI file),�o�˴N���ݭn�h�Ҽ{��v���P�B�����D,��Raw Data�����P�B��w�ۤv�h��,�ڭ��n�����Y���榡�D�n�O��MPEG Layer

III,�v�����Y�D�n�O��MPEG4,�̫�X���@��RIFF-AVI�ǰe�L�h�C

Mpeg Audio

Mpeg Audio�O��Frame by Frame���x�s�覡,�@��Frame�N�O�@�ӳ̰�������,Mpeg

Audio���ɮ��c�p�U:

FRAME1

FRAME2

31 0(bits)

Header�����z�p�U(�Բ�����T�i��̫�C�X���ѦҸ�ƴM��,�]����ӽg�T�Ӥj�F,����K�C�X)

|

Sign |

Length(bit) |

Position(bit) |

Description |

A |

11 |

(31-21) |

Frame sync (all

bits must be set) |

|

B |

2 |

(20-19) |

MPEG Audio

version ID |

|

C |

2 |

(18-17) |

Layer

description |

|

D |

1 |

(16) |

Protection

bit |

|

E |

4 |

(15-12) |

Bitrate index |

|

F |

2 |

(11-10) |

Sampling rate

frequency index |

|

G |

1 |

(9) |

Padding bit |

|

H |

1 |

(8) |

Private bit.

This one is only informative |

|

I |

2 |

(7-6) |

Channel Mode |

|

J |

2 |

(5-4) |

Mode

extension |

|

K |

1 |

(3) |

Copyright |

|

L |

1 |

(2) |

Original |

|

M |

2 |

(1-0) |

Emphasis |

Mpeg Audio Frame Length

���Y����T�ڭ̤w�g�ԲӪ��D�F,�ܩ�Raw

Data�����ץi�H�ѥH�U�����p��X�ӡC

Read

the BitRate, SampleRate , Padding bit and protection bit(CRC) from header.

For

Layer I files us this formula:

FrameLengthInBytes

= (12 * BitRate / SampleRate + Padding) * 4 + CRC

For

Layer II & III files use this formula:

FrameLengthInBytes

= 144 * BitRate / SampleRate + Padding + CRC

Mpeg4

Mpeg4�������Y�k�ä��O�ܲM��,�i�H�ѦҨ�SPEC,�ڭ̬O��DivX

MPEG4 Video Codec(filter)�ӹF���ڭ̪��ت��C

RIFF(defined by Microsoft)

�]��AVI��ORIFF�榡���ɮ�,�]����²��RIFF�CRIFF(Resource

Interchange File Format)�O�@�ӤG�i�쪺�_�����c�ɮ�,���ä��N������h�C���ɮ�,�ӥ��O��h�C���ɮץ]�˦b��w�q�����c����,�]�˦bRIFF�����h�C���ƥD�n�O�H�ɮת����ɦW�ӧP�O,�p�U�ҦC:

�P

Audio/visual

interleaved data (.AVI)

�P

Waveform

data (.WAV)

�P

Bitmapped

data (.RDI)

�P

�P

Color

palette (.PAL)

�P

Multimedia

movie (.RMN)

�P

Animated cursor (.ANI)

�P A bundle of other RIFF files (.BND)

�p�W���ORIFF�榡���ɮ�,�u�O�䤺�t���h�C���Ƥ��@���C�A�ӭn�������ORIFF���c,�bRIFF�������N�OChunk,�p�U�ҦC:

typedef struct _Chunk{DWORD ChunkId; /* Chunk ID marker */

DWORD ChunkSize; /* Size of the chunk data in bytes */

BYTE ChunkData[ChunkSize]; /* The chunk data */

} CHUNK; ChunkData���S�i�]�t�O��Chunck(Sub

Chunk),�o�˪����Y�@���U�h�N�p�W�Һ٪��_�����c�C

AVI

AVI�ݩ�p�W�z��RIFF�榡,AVI���\���ɮ�ƥ]�A�F�n���P�v��,����Chunk�����p�U:

struct _RIFF /* "RIFF" */

{

RIFF CHUNKstruct _AVICHUNK /* "AVI " */

{

struct _LISTHEADERCHUNK /* "hdrl" */

{

AVI CHUNK

AVIHEADER AviHeader; /* "avih" */

struct _LISTHEADERCHUNK /* "strl" */{

LIST-HDR CHUNK

AVISTREAMHEADER StreamHeader; /* "strh" */

AVISTREAMFORMAT StreamFormat; /* "strf" */ AVISTREAMDATA StreamData; /* "strd" */ }

}

struct _LISTMOVIECHUNK /* "movi" */

{struct _LISTRECORDCHUNK /* "rec " */

LIST-MOVI CHUNK

{

/* Subchunk 1 */ /* Subchunk 2 */ /* Subchunk N */ }

}

struct _AVIINDEXCHUNK /* "idx1" */

{

INDEX CHUNK

/* Index data */

}

}

}

�p�W�ҦC,�o�O�@��AVI�����c�ɮ�,�D�nRIFF

chunk�]�ˤ@��AVI chunk,AVI chunk�����S�]�t�F,LIST-HDR�BLIST-MOVI�BINDEX�T��chunk,LIST-HDR

chunk�����D�n�O�����v����ƪ���T,LIST-MOVI chunk�O�\�v�����,INDEX chunk�O�\�v�����ת�����,�D�n�O���ѧ���ΰj��v������T,�̭���ӳ������e�i�H�Ѧҫ᭱�C�X���ѦҸ��,�]���g�T����b�Ӥj�F�C

Summary

�ä��O�Ҧ����榡���O�A�X�b�����W���ǰe,�\�h���h�C��ǰe�����q�����t�~�ۭq���ɮ榡,�pReal

Player RA�άOMicrosoft ASF,������AVI�榡�N�v���ǰe�X�h�]���O�ܲM���O�_�u���X�A,�o�ݭn��J�Ӫ���s�~��C

�� �t��B�[�c

![]()

![]()

�p�W�ϬO�ڭ̪�B��@�X���[�c,��������ݱqDISK���X�n����AVI

File�����ΨîM�WRTP��Multicast�ǰe������ݡC����ݥ]�tReceiver�PPlayer�ⳡ��,�����O�b�P�@�{�����Ӥ��P��Thread����C

����ݱ������ƫ�N�NAVI���q�g�JDISK,�̫�Player�N�g�J��AVI���q������X�ӡC

�o��N�X�{�F�@���Z���쪺�{�H,�N�O�ڭ̶ǰe�ݻP����ݪ��t�n�p����,�٦��������W�e���D�O?!�W�ǰe�ݬO�ھ�AVI���q���רӽվ�t�ת��C�γ\�i��S�|�ݬ�����ݭn�z�LDISK�s���o�D����,�����쪺AVI���q��RTP

Packet�@�}�l���N�O�b�O���餤,������������X��?!�D�n����]�O�]��Player�O��DS�ӹ�@,��DS���ɴ��Ѫ�Source Filter�u��qURL��FILEŪ��Raw

Data,�]�ӧڭ̱�FILE���覡,�ҥH�n�z�LDISK�Ӥ��O�qMemory�L�h,���@�z�LDISK���覡,�ڭ̵oı�b����AVI���q�����|���dz\Delay�C

�����责�쪺�D�n�ʥ��ڭ̤]�Q�ת�@�ǸѨM���,���O�̦n���N�O�����z�LMemory��DS�B�z,���γo�˩���s�Y��į�,�o�N���ܻ��ڭ̻ݭn�h�}�o�@�ӯ�q�ۭq�O����BufferŪ��Raw

Data��Source Filter,�ܩ�o�ӳ����ѩ�ɶ������\,�]���|����@�C

�� �t�γ̫�[�c

![]()

![]()

�̫᪺�t�ά[�c�p�W�ϩҥ�,����ݥ����S����,�Ӧb�ǰe�ݧאּ����Capture

(CCD & MIC Device)���o�h�C��,�N���o���h�C����g�JDISK,�̫�Sender�A�N�g�JDISK���v���ǰe�X�h,��Send�PCapture��ڤW�O�P�@�{��,��Run�b���P��Thread�C

�W�ǰe�ݤ]�O�����Ҵ�����f,���O�����z�LDISK��,�o�ˤS���O���@�Ǩt�ήį�,�ӥB�ĪG�S���O�ܦn�C

�� �t�ά[�c��--

DirectShow Filter

Audio Capture Filter

![]()

![]()

![]()

![]()

![]()

![]()

![]()

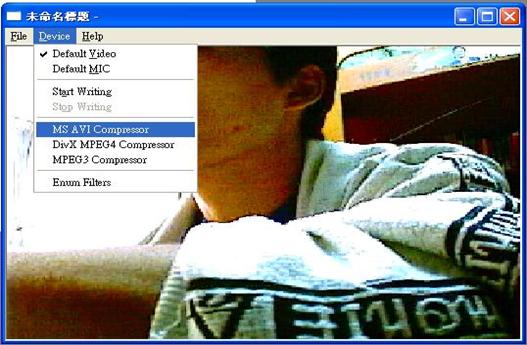

�p�W�ϱNCapture�PSender�����i������DS

Filter�s�����p�COptional�����O���i�H������Y�覡�Τ����Y,�v���䴩DivX MPEG4 Video Compressor�BMicrosoft

AVI Compressor,�n���譱��MPEG Layer3 Compressor,���o�譱�i�H�ھڨt�ξ֦���Compressor�ӿ�ܡC

�� �ǰe��Screen

Shot

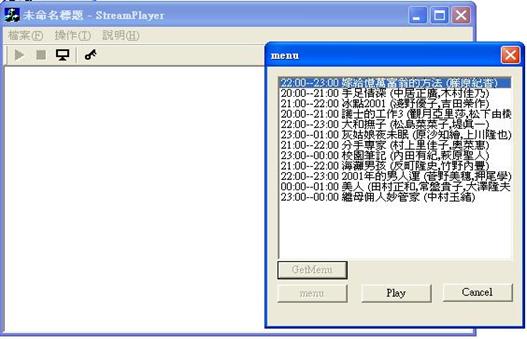

�p�ϥ��U,�D�n���Ҧ��\�ೣ�b���U�Ԫ�Menu����,�]�A�O�_�n�^���v�����n���B�O�_�䴩�Y�����Y�C���Start

Writing�N�|�}�l�@�ǰe�������v��,Stop�|�Ȯɰ���ǰe�ʧ@,�ťճ����OPreview����(�p�U�ϵe��)�C

�Ϥ@�G�}��Video Capture�ɡA�۰ʥX�{Capture

property����

�ϤG�G�ާ@���A�i�H��ܼv���B�n���^���A�H�����Y�榡

�� ������Screen

Shot

�ϤT�G�`�ؿ�����

�ϥ|�G����CCD�MMIC�Y���^�����v���B�n��

�� ��O

�o�ӱM�D���Ǧa��O�ȱo�~���s�B�ﵽ��,�ҦpRTP/RTCP������ϥΡBDS������gFilter�ӱ���Raw

data��data flow�θյۨϥ� DS������RTP Filter�C

�`�Ө���,�o�����M�D���ڭ̱�IJ��\�h�H���S��IJ�����, �A����Ǫ��@�ǾǪ��j�̤]�O,�]���\�h�F�賣�n��O�Z�h���ɶ��h��s�M�j�M���,�䤤���������յ{���]�ܦh,�]�A�FMulticast�ɮǿ�BMPEG

Audio�ɮפ��ξ��BDirectShow����v���B�n�������սd�ҡBRTP�ǰe�B�������յ{��,�Ⲥ��Microsoft Direct Show���[�c�M�N�B�]�Ƿ|COM���]�p����,���F�o�Ƿ����P��@����¦,�Q�A�`�J�U�h�]���|�p���}�`�C

�� �ѦҸ��

l

Online MSDN (http://msdn.microsoft.com/library/)

l

Microsoft DirectShow 8.0a SDK Document (see DX

SDK)

l

JRTP Library Document (http://lumumba.luc.ac.be/jori/jrtplib/jrtplib.html)

l

RTP Official Site (http://www.cs.columbia.edu/~hgs/rtp/)

l

RFC 1889 RTP

l

������RCOM Dale

Rogerson Microsoft Press

l

AVI RIFF FORMAT

(http://www.oreilly.com/centers/gff/formats/micriff/index.htm)

l

DirectX, RDX, RSX, and MMX technology : Rohan

Coelho and Maher Hawash Addison-Wesley Development Press

l

���^��,��IP Multicast �s������²����,1998.3

�� ��v���M�{���X�U��

=======================

--CCD Capture & Sender �{���X (CCD_sender)